Ayer se celebró el OpenAI DevDay, la primera conferencia para desarrolladores de la empresa que puso en boca de todo el mundo las IAs generativas, hace menos de un año (parece que hace un siglo con todo lo que ha pasado).

Y el evento no defraudó. Un montón de novedades, anuncios y lanzamientos que no dejaron a nadie indiferente.

Puedes ver la Keynote completa del evento en YouTube, pero para ahorrarte tiempo, te contamos todas las novedades a continuación, por categorías.

Nuevo modelo GPT-4 Turbo

Al igual que pasó en su día con GPT-3, el LLM más moderno de la empresa tiene ya su versión "Turbo". Esta versión ofrece una ventana de contexto de 128.000 tokens, enorme, capaz de "recordar" hasta unas 90.000 palabras de una conversación (cálculo aproximado, claro, ya que depende de los contenidos concretos, el idioma y otros factores). Este tamaño de contexto nos permite meter en su memoria de corto plazo, por ejemplo, el primer libro de la trilogía del Señor de los Anillos. Abre más posibilidades a la hora de generar conversaciones coherentes o textos de gran tamaño.

También han ampliado el entrenamiento del modelo, cuyos conocimientos ahora terminan en abril de 2023, o sea, que en estos momentos conoce casi todo hasta tiempos muy recientes.

Ya es posible acceder a la API con este nuevo modelo (aunque con ciertas limitaciones en cuanto a peticiones de momento), pasando el valor gpt-4-1106-preview para indicar el modelo deseado. Antes de que acabe el año sacarán la versión definitiva.

En la nueva versión de la API han añadido la capacidad de llamar a varias funciones en un mismo mensaje, que se ejecutarán de golpe ahorrando idas y venidas, pero sobre todo una mejora sustancial a la hora de devolver JSON, el JSON Mode. Una forma habitual de utilizar finalizaciones de chat es indicarle al modelo que siempre devuelva JSON en algún formato que tenga sentido para nuestro caso de uso, proporcionando así un mensaje del sistema. Esto funciona bien generalmente, pero a veces los modelos generan resultados que no resulta que no son JSON válido. Con este nuevo modo, puedes establecer el parámetro response_format como { type: "json_object" } y el modelo se restringirá a devolver tan solo JSON y garantizar que siempre va a ser válido. Un quebradero menos de cabeza para los desarrolladores. Estas mejoras también están disponibles para GPT-3.5 Turbo.

En cuanto a la reproductibilidad de las respuestas del modelo, algo de interés en ciertos tipos de aplicaciones, han añadido a la API del modelo una nueva característica en beta llamada salidas reproducibles enfocada a ese caso de uso.

GPT-4 Turbo en su variante gpt-4-vision-preview ahora soporta entradas visuales en la API de completitud, utilizada para crear asistentes de conversación (chats). Esto permite hacer análisis visual de cualquier imagen que le pasemos, pudiendo describirla, extraer texto, etc... Aunque de momento se expone a través de ese modelo específico, cuando saquen la versión final en unas semanas, ambos se fundirán y podrás hacer entrada de imágenes y texto a la vez desde GPT-4 Turbo.

Por fin, como guinda del pastel, han anunciado una considerable bajada de precios para este nuevo modelo GPT-4 Turbo. Los tokens de entrada cuestan ahora un céntimo de dólar por cada 1.000 tokens (3 veces más baratos que antes), y los tokens de salida (generados) son 3 céntimos de dólar por cada mil (la mitad de precio que antes).

Mejoras en GPT-3.5 Turbo

La versión GPT-3.5 Turbo-1106, el hermano menor del modelo anterior más que suficiente para la mayor parte de las tareas de un LLM, tiene ahora por defecto 16.000 tokens de contexto (4 veces mayor que antes), y encima también es más barato (tan solo 1 céntimo de dólar por cada 10.000 tokens de entrada, o 3 céntimos por 10.000 tokens generados).

Si eres de los que le interesa hacer ajuste fino del modelo (fine tuning) para su caso de uso, en lugar de apoyarte en una base de datos de vectores (que será lo que hagas en la mayor parte de los casos), pues te alegrará saber que también han bajado los precios mucho. Esta nueva versión del modelo se puede ajustar, y los precios de uso del modelo adaptado resultante han bajado un 75% y un 62% respectivamente para los tokens de entrada y de salida (aunque son el triple de caros que los del modelo sin afinar).

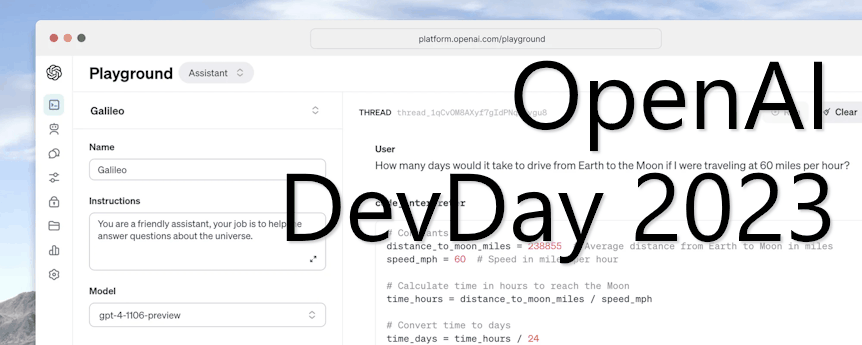

Nueva API de asistentes

Este es un gran anuncio que va a impactar a multitud de empresas que están en el nicho de asistentes virtuales basados en la API de Open AI.

Todavía en beta, la nueva API de Asistentes permite crear con extrema facilidad aplicaciones específicas para agentes inteligentes en forma de chat, como por ejemplo tu propio asistente para programar, tu propio planificador de vacaciones o tu analista de datos personalizado. La imaginación es el límite.

Te lo dan todo hecho: la creación del agente que siga unas instrucciones de base específicas, el procesamiento y consulta de archivos de multitud de tipos que se usen como información de contexto (imaginamos que almacenan de manera transparente para ti los embeddings en una base de datos vectorial y facilitan su búsqueda), la creación de conversaciones persistentes a largo plazo que evitan los límites de la ventana de contexto...

Además la nueva API trae de serie tres funcionalidades brutales:

- Intérprete de código: capaz de escribir y ejecutar código Python en un entorno aislado para resolver problemas en tiempo real y devolver los resultados. Permite generar gráficas y procesar archivos de código.

- Recuperación de información: para aumentar el "conocimiento" del modelo a partir de fuentes externas, como documentos, manuales, información de productos... Esto significa que te ahorras procesar los archivos, trocearlos para crear los embeddings, almacenarlos en una base de datos vectorial, hacer búsquedas por semejanza en ésta, etc... Más fácil imposible y todo desde la API. Por supuesto con el compromiso de poder borrarlos cuando quieras y de que no los van a utilizar para entrenar sus modelos.

- Llamada a funciones: puedes hacer que el modelo llame a ciertas funciones propias en remoto e incorpore la información a su contexto o a sus respuestas. Por ejemplo, imagina un asistente para hacer planes de vacaciones que pueda consultar en tiempo real las condiciones meteorológicas en el destino de cada usuario para dar recomendaciones adaptadas a ello.

Básicamente se acaban de cargar de un plumazo a cientos de pequeñas empresas que usan su API para ofrecer a los desarrolladores todo esto.

Es seguramente lo más importante que han presentado en el evento.

GPTs: Nueva característica para extender tu propio chatGPT

Y otro anuncio "bomba" más: ahora puedes crear tus propias versiones de chatGPT a las que le puedes añadir tus extensiones personalizadas para hacer casi cualquier cosa. Las han denominado de forma bastante confusa como GPTs, así en plural 😒

Es algo muy parecido a los plugins de chatGPT (de hecho es muy fácil transformarlos en unos minutos para adaptarlos a esto), pero usándolos con la API para tu propia versión de chatGPT. De este modo, además de sacarle toda la potencia que ya tiene el modelo de base de chatGPT (incluyendo la generación de imágenes con DALL-E o el análisis de datos), puedes crear acciones propias que hagan otras cosas: desde conectarse a la base de datos de tu empresa a convertirlo en especialista en un juego de rol para dar soporte a sus usuarios. La imaginación es el límite.

Estas extensiones se podrán incluir en una tienda de GPTs para venderlos o cederlos a otros y, por supuesto, si se trata de extensiones que manejan información confidencial pueden ser totalmente privados (para clientes "empresariales" tan solo, aunque seguramente Microsoft lo ofrecerá ya de serie en la API de OpenAI albergada en Azure).

Otros detalles

Además anunciaron algunos detalles más de otros modelos no-LLM:

- Mediante la API de generación de imágenes ya puedes utilizar DALL-E 3.

- Mejoras en la [generación de voz a partir de texto](https://platform.openai.com/docs/models/tts), con una nueva versión del modelo, con voces más naturales y mejor entonación (en inglés).

- Modelos totalmente personalizados: para aquellas empresas "selectas" con necesidades específicas (y suponemos que mucho dinero) a las que los modelos actuales no les sirvan ni siquiera afinándolos, ahora ofrecen la posibilidad de trabajar con un equipo de expertos dentro de OpenAI para crear versiones nuevas de LLMs para sus necesidades.

Con todas estas novedades y lo que está haciendo la competencia, tenemos unos meses emocionantes por delante. ¡Síguenos para mantenerte al día!